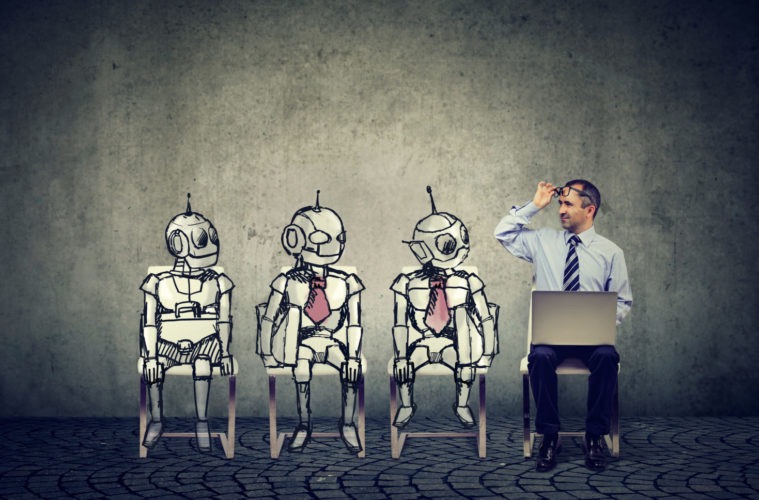

AI不会取代人类,但使用AI的人将取代不使用AI的人

原文:AI Won’t Replace Humans — But Humans With AI Will Replace Humans Without AI 内容要点: 与互联网大大降低了信息传输的成本一样,AI将降低认知的成本。 虽然很多人担心AI会取代人类的工作,但真正的趋势是,拥有AI技能的人类将会取代那些没有AI技能的人类。这意味着AI不是一个威胁,而是一个工具,可以增强人...

原文:AI Won’t Replace Humans — But Humans With AI Will Replace Humans Without AI 内容要点: 与互联网大大降低了信息传输的成本一样,AI将降低认知的成本。 虽然很多人担心AI会取代人类的工作,但真正的趋势是,拥有AI技能的人类将会取代那些没有AI技能的人类。这意味着AI不是一个威胁,而是一个工具,可以增强人...

原文:Quick thoughts on research 创新研究的原则和启示引言 作者分享了自己在理论物理、计算机科学、思维工具和元科学领域的经验,提出创新研究工作的原则和启示。 强调分享研究思考对整个研究社区的益处。 警惕普适原则 研究原则不是普适法则,因人而异,因情况而异。 需要一系列灵活的启示,适应不同的情况和变化。 在事情进展顺利时,继续保持,而在陷入困境时,尝试其他启示。 坚...

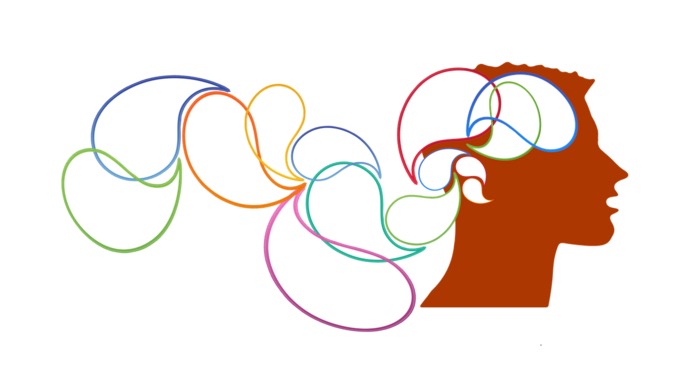

原文:The Fall of Stack Overflow, Explained Stack Overflow 的衰落一篇名为《Stack Overflow的衰落》的文章迅速传播,用数据详细描述了 Stack Overflow 在过去一年半流量下降了35-50%。 1. 原因一:Google Analytics 的变化2022年5月,由于隐私法律的原因,Google Analytics 改变...

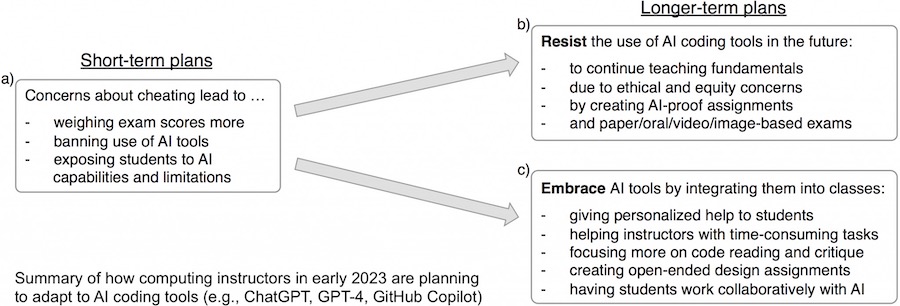

原文:Teaching Programming in the Age of ChatGPT 在ChatGPT时代教授编程:计算机教师的适应计划主要信息 ChatGPT等AI编程助手的出现引发了计算机编程教师的关注,他们面临如何调整教学策略的挑战。 短期计划:教师希望阻止学生作弊,避免依赖AI工具,采取一些应对措施,如限制工具使用、强化考试方式等。 长期计划(抵制AI工具):教师担心学生可能不...

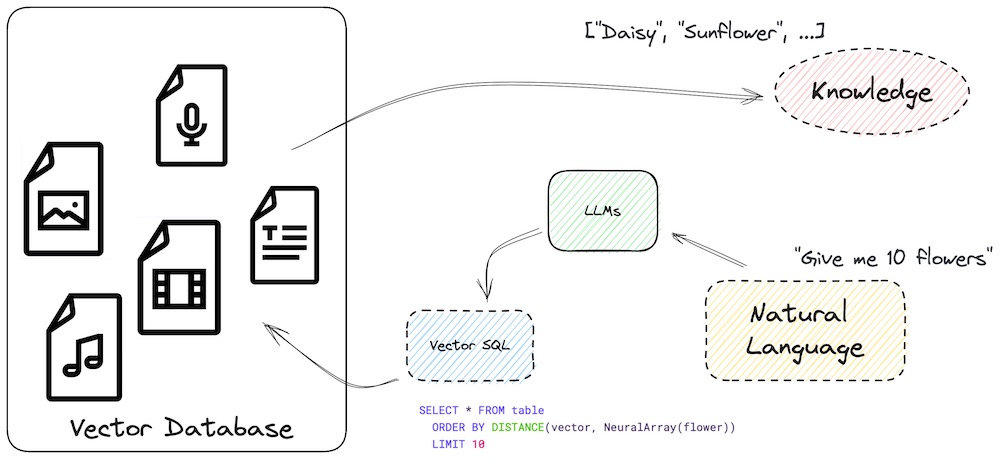

原文:Teach your LLM to always answer with facts not fiction LLM幻觉与使用Vector SQL减少幻觉主要信息 LLM(Large Language Model)是一种高级AI系统,可以回答广泛范围的问题,但在陌生话题上可能出现幻觉现象。 幻觉是指在缺乏外部刺激的情况下,产生具有真实感知质量的感知错误。 增加外部知识可以减少LLM幻觉...

非常认同Andrej Kalpathy在“State of GPT”报告里分享的观点(以下为宝玉搬运字幕版,中文翻译质量很高),结合我的思考进一步阐述如下: 微软2003年Build大会演讲:如何训练和应用GPT 人和大模型之间最大的差距,在于思考过程和追求答案的方向。 人有内心独白,会调动经验,拆解问题,进行复杂的思考过程,追求合理、准确的答案,注重答案从内容到形式的“优雅”,即我们常说的...

先说结论:规模是把双刃剑,平衡点需具体权衡。 从大模型记忆论的观点来看,模型规模越大,参数越多,记忆容量越高,对整体数据分布的把握就越全面,可以增加模型在推理时的工作记忆,生成更具创新性、更多样的结果。但与此同时,随着熵增,高概率候选结果的多样化会呈指数级爆发,这就带来了一个挑战:如何在这些结果中进行优选,使得模型的输出与人类的价值观对齐。 从大模型压缩论的观点来看,大模型的目标是通过压缩世...

医疗除了技术问题以外,也许更重要的,会涉及对人类情感的理解和关怀。尽管AI能处理大量数据,但其在理解人类情绪和个体经历方面有限。这对处理如慢性病管理和心理健康问题等多元健康问题显得尤为重要。 每个病人都是独特的,需要全面、个性化和富有同情心的医疗服务,也就是个性化的诊疗服务。尽管AI能有效处理和分析大量信息,但其决策基于已有数据和已知规则,对新颖和独特的情况可能无法有效应对。 AI系统的构建...

原文:The Most Important Coding Habits 作者在康复期躺着写下这篇文章,因为腰椎间盘突出导致了滑脱症状。他通过自己的痛苦体会认识到,最重要的编程习惯并不是代码的可读性、一致性、组织结构等方面,而是那些让我们能在未来数十年继续享受编程乐趣的习惯。 文章提到了几个重要的编程习惯,以避免因长时间久坐在键盘前而导致的健康问题: 每日伸展:定期进行腹部和大腿肌肉的伸展运...

让我们从一个不那么恰当的类比开始——一个人,通过读自己原创的书稿,能受到新的启发、获得能力的提升吗?不必急着回答,因为AI大模型的学习机制,和人类的学习机制,是截然不同的。但可以肯定,至少有一点人比AI靠谱——人不会因为看自己的作品失忆、变坏、变笨,目前的AI呢,还真不一定…… 首先,AI生成的数据良莠不齐,且难以分辨。以目前的大型语言模型(LLM)为例,在生成文本时,通常会在每个步骤中做出...